Born to blossom bloom to perish

Blog info

Deeario è il blog di Tony Siino.

In questo momento mi trovo a Palermo (Italia).

Informazioni estese su questo blog sono racchiuse nel colophon. Contatto: e-mail.

Copyright 2001-25. Tutti i diritti sono riservati.

In questo momento mi trovo a Palermo (Italia).

Informazioni estese su questo blog sono racchiuse nel colophon. Contatto: e-mail.

Copyright 2001-25. Tutti i diritti sono riservati.

Categorie

- acid (71)

- blogosfera (194)

- cinema (21)

- Deeario (42)

- frasi (21)

- ICT e www (311)

- intimistica (328)

- musica e radio (148)

- Palermo (78)

- politicate (107)

Archivi

Bloglegamenti

- :.:.: (il blog di) Daniele Minotti

- .Questo non è un Blog.

- [mini]marketing

- *dotcoma

- <edit>

- Aghenor Blog

- Akille.net

- Andrea Beggi

- ANDREAXMAS

- apartment therapy

- apophenia

- AXELL WEBLOG

- bigoutblog

- Blog Notes

- boingboing

- BREAKING ZEN

- Buba [ una foto al giorno ]

- Burekeaters

- busblog

- BXL BLOG

- camillo

- Catepol 3.0

- CENTRAL SCRUTINIZER

- Cloridrato di sviluppina

- CristianContini

- cronache di…

- Davide Salerno

- digg

- Drops of me

- EmmeBi

- engadget

- Enlarge my penis…

- fubiz

- Futablog

- Fuuuuuuuuuuuuuuuuu

- GASPAR TORRIERO GONE VERBOSE

- giamo

- Giavasan

- GIZMODO

- I blog it!

- i media-mondo

- Il blog di Sergio Maistrello

- Il Disinformatico

- Il Mestiere di Scrivere

- inhabitat

- INSERT COIN

- Kitta.net

- Le stanze di Gaia

- Loobylu

- Luca De Biase

- Luca Sartoni

- Luciano Giustini

- Macchianera

- manteblog

- Marco Massarotto

- Mauro Lupi’s blog

- MOCOLOCO

- Mushin

- Nicola Mattina

- Nocturns

- NonSoloSecurity Blog di Feliciano Intini

- Pandemia

- PAOLO'S WEBLOG

- PERSONALITÀ CONFUSA

- Photographer’s Life

- Preshrunk

- Proesie

- pseudotecnico:blog

- Raymi the Minx

- Rion Nakaya

- Robert Scoble's Augment Your Life

- sai tenere un segreto?

- Secret Rome

- Sex in Art

- Simply my Blog – Il Blog de LaFra

- SmartMobs

- Stefano Epifani

- SWISS MISS

- TechCrunch

- The Right Nation

- The Web Observer

- vacant.cc

- Vassar storie(s)

- Vincos Blog

- WEBGOL

- Wittgenstein

ISSN 1825-9081

Ma quanto ci vorrà perché facciano macchine fotografiche a 576 megapixel?

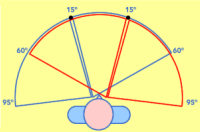

Onestamente non credo che il pixel (o il suo multiplo Megapixel) sia una unità di misura idonea per quantificare la porzione di spazio percepita dall’occhio umano. Il pixel ha più senso se rapportato con la qualità (la precisione) della porzione di spazio “acquisita” dall’occhio.

Chi conosce un minimo i programmi di grafica sa che in 1000 pixel ci puoi far entrare 10 100 o 1000 millimetri.

Decisamente anche l’occhio vuole la sua parte…di megapixel

Sciura Pina

Smeerch, invece è davvero appropriato usare il pixel (o comunque unità discreta) per misurare la definizione dell’occhio umano. Nella retina ci sono fotorecettori in quantità finita dopotutto.

La differenza più marcata è che questi non sono organizzati in una griglia ortogonale e (soprattutto) che hanno una concentrazione variabile (alta al centro, molto bassa alla periferia). In realtà l’occhio “fotografa” un’immagine piuttosto scadente: se il cervello non facesse un lavoro incredibile di compensazione e di micromovimenti della pupilla non vedremmo un tubo. :)

Se consideriamo che tra coni e bastoncelli ne abbiamo al massimo 160 milioni per occhio, volendo fare un’approssimazione di un pixel per cellula, otteniamo 160 megapixel, indipendentemente dalla distribuzione o dal campo visivo. Poi potrebbe essere che ogni cellula rilievi più di un “pixel virtuale” quindi si potrebbe moltiplilcare. ma credo che già 160 megapixel potrebbe andare. Oppure si potrebbe prendere il campo visivo e dividerlo per il dettaglio minimo che l’occhio può vedere, che è 15 secondi d’arco, quindi (prendendo il dato da sopra) 120*60 gradi sono 432000*216000= 93312 milioni di secondi d’arco quadrati che diviso 15^2 fa 414.720.000 di pixel, quindi 414 megapixel, forse questa stima è la più corretta..